L’intelligence artificielle est partout ces temps-ci. Selon qui vous en parle, elle va révolutionner notre vie, nous piquer nos jobs, gouverner le monde à notre place, nous rendre surhumains ou obsolètes, assurer la sécurité de nos routes, mettre fin à nos libertés, nous faire rois ou esclaves, inventer son propre successeur (et le nôtre) dans une singularité récursive infinie… la boîte de Pandore est ouverte – mais que contient-elle de fantasmes, de mythes anciens modernisés, de réalité exaltante ou effrayante ?

Intéressant et ironique retour des choses, pour votre chroniqueur comme pour toute une génération d’ingénieurs et de chercheurs en informatique qui ont comme lui commencé leur carrière dans les années 80. Le domaine était alors porteur, et source de maints financements de thèses ; mais pendant toutes les années 90 à 2010 nous fûmes plutôt tentés de maquiller nos CV pour faire oublier nos errances passées – car il était mieux vu, à l’époque, d’avoir passé cinq ans sous les barreaux pour cybercriminalité financière que d’avoir gaspillé l’argent du contribuable ou des grands sociétés de technologie dans ce qui apparaissait comme une voie sans issue, un espoir déçu, une arnaque presque. Trop de promesses non tenues, un bon mélange d’hybris médiatique et de naïveté, et quelques projets spectaculairement loupés semblaient avoir sonné le glas de la discipline.

Qu’est-ce qui a donc changé depuis ? Pas forcément ce que l’on croit. Les algorithmes dont on nous rebat les oreilles ces temps-ci ne viennent pas de nulle part : pour beaucoup, leurs racines remontent aux années 70 voire avant. Les réseaux de neurones convolutifs, qui sont à la base de ce que l’on appelle l’apprentissage profond au cœur de l’IA moderne, doivent leur succès actuel – par exemple en reconnaissance et en classification des images – à la capacité incroyable de calcul distribué et à la masse inconcevable de données d’apprentissage disponibles dans le cloud ; mais les concepts sous-jacents ont été élaborés progressivement depuis plus de trente ans, et s’inspirent eux-mêmes d’études neurobiologiques sur le cortex visuel menées dans les années 50 ou 60.

Ce qui a changé, c’est donc d’abord la quantité de données disponibles et les moyens de calcul pour les traiter. Un algorithme d’intelligence artificielle doit apprendre à effectuer sa tâche ; pour cela il faut lui fournir un (très) grand nombre d’exemples. Si vous voulez entraîner un algorithme à reconnaître les images de chat sur Internet, il faut d’abord lui fournir des flopées d’images de chat – et des flopées d’images d’autres choses, les unes et les autres étiquetées comme telles. L’algorithme va se confronter à chacune de ces images, ajustant ses paramètres progressivement jusqu’à distinguer correctement les exemples des contre-exemples, puis pourra – s’il a par ailleurs les bonnes propriétés – prédire avec un bon niveau de confiance si une nouvelle image qu’on lui soumet représente un chat, ou non. Les calculs nécessitent une grande capacité de traîtement ; l’abondance de données est essentielle. Facebook, Google, Amazon et les autres fournissent les deux. Il est permis de s’en réjouir comme de s’en alarmer, mais force est de constater que ça marche.

Ce qui aussi changé – et c’est un point essentiel à prendre en compte dans les débats actuels – c’est l’objectif poursuivi. Le but premier de l’intelligence artificielle des origines était de comprendre et reproduire le raisonnement humain, voire la conscience elle-même – ce que l’on appelait l’Intelligence Artificielle forte. Nous cherchions à formaliser la connaissance des experts mais aussi le sens commun de tout un chacun ; nous inventions des systèmes logiques capables d’exprimer mathématiquement des affirmations portant sur le monde, d’en inférer des nouvelles connaissances, et même de généraliser ces dernières en règles permettant d’interpréter des situations inconnues ou hypothétiques ; nous parlions systèmes experts et apprentissage symbolique. De fait, cela ne marchait que dans des modèles ultra-simplifiés du monde ; le monde réel était tout simplement trop riche de détails impossibles à formaliser. Cependant, pertinent ou pas, il nous était toujours possible de comprendre le raisonnement qu’effectuait la machine. Naïf, certes : mais transparent.

L’approche – à l’époque dite connexionniste – qui triomphe actuellement opère avec des buts bien plus humbles. Elle n’a cure de reproduire le raisonnement humain – sans même parler de la conscience ; elle cherche à résoudre des problèmes purement mathématiques, en utilisant des algorithmes d’optimisation massivement distribués dont les composants de base – les neurones – opèrent des opérations simples. Chaque neurone calcule une valeur numérique en sortie qui combine plusieurs valeurs reçues en entrée (lesquelles peuvent elles-mêmes provenir de l’image à tester, ou des sorties d’autres neurones situés en amont). Chaque neurone fait cela de son côté en utilisant des paramètres, comme la « force » de sa connexion avec un neurone en amont, qui peuvent être modifiés. Que cherche réellement à faire notre algorithme d’apprentissage de reconnaissance de chats ? Il se moque bien des chats. Il essaie, en jouant sur les paramètres ajustables de chaque neurone, de minimiser l’écart moyen entre la prédiction qu’il opère (la valeur de sortie de ses neurones les plus en aval) et la réalité de chaque exemple. Ce qui émerge alors, c’est un comportement collectif des neurones qui fonctionnera comme un spécialiste du chat ; mais ni le concept de chat, ni aucune de ses propriétés – pattes, moustaches, griffes, que sais-je – n’existe dans ce système. De fait, cela marche plutôt bien ; mais, pertinent ou pas, il nous est à peu près impossible de comprendre le calcul de la machine. Efficace, certes : mais cryptique.

Comment faire confiance à un algorithme dont on ne comprend pas le raisonnement ? Comment, donc, rendre compréhensible ce qui se passe dans la boîte noire ? C’est l’un des défis identifiés à juste titre par la CNIL dans un récent rapport.

Cela n’a pourtant rien de simple. En étudiant le comportement des réseaux de neurones, les chercheurs vont même de surprise en surprise. Un logiciel spécialisé dans la reconnaissance des styles musicaux s’est ainsi révélé ignorer toutes les fréquences supérieures à 40 hertz : il fonde sa reconnaissance uniquement sur les fréquences basses inaudibles à l’oreille humaine ! Difficile pour un musicien de ne pas se sentir au mieux interloqué.

D’autres algorithmes ont été surpris à effectuer des recommandations clairement biaisées par une discrimination raciale ou sexuelle, sans bien sûr que cela ait jamais été prévu par les concepteurs : pas plus qu’un chat, l’algorithme ne sait ce qu’est une minorité. Mais qui sait quelle part d’inconscient transparaît dans les choix d’exemples et de contre-exemples fournis au logiciel ? Le web lui-même porte nos préjugés, nos biais, nos ethnocentrismes : le donner à consommer tel quel aux algorithmes est déjà dangereux, comme Microsoft l’a appris récemment – qui a dû retirer précipitamment des réseaux sociaux une IA dont le discours était devenu, en quelques jours seulement, raciste, sexiste et haineux.

Pour couronner le tout, un algorithme qui ne raisonne pas comme un humain peut de ce fait être induit en erreur par des artifices qui ne tromperaient pas un humain deux secondes (ces photos sont particulièrement éclairantes). Il est donc possible de « hacker » un algorithme : comment le protéger si nous ne comprenons pas ce qu’il fait ?

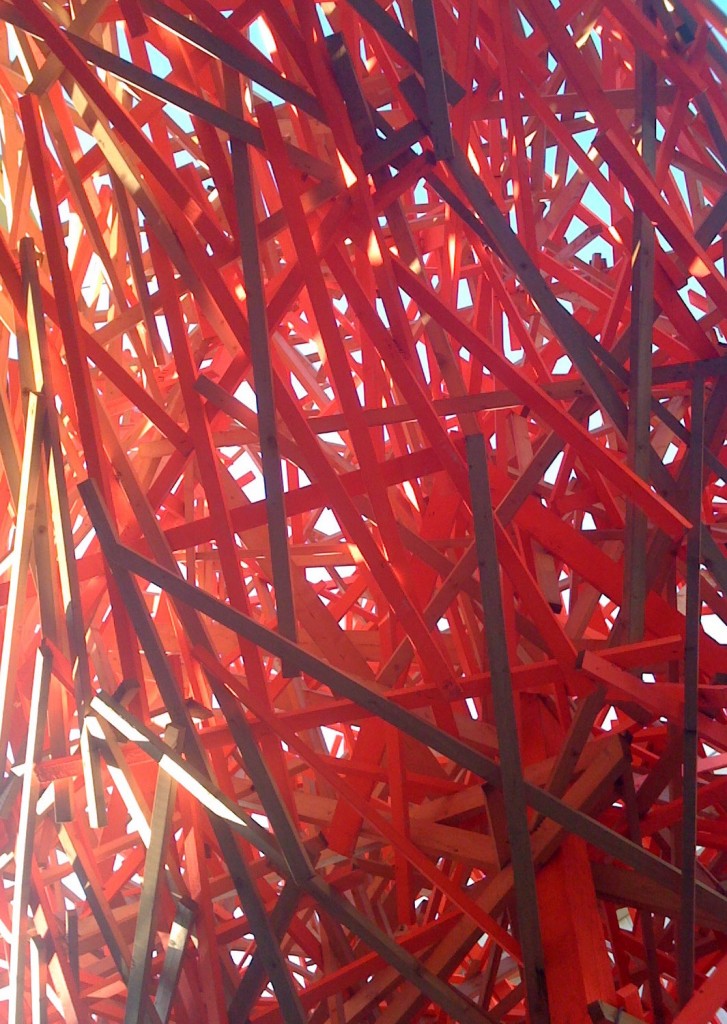

Une très belle illustration de cet effort d’introspection est fournie par le logiciel Deep Dreams, récemment mis dans le domaine public par Google, et qui nous montre (par exemple ici) comment leur logiciel de reconnaissance visuelle « voit » des photos que nous lui soumettons à certains stades de traitement. C’est fascinant et beau. Mais comprenons-nous vraiment ce qui se passe, et pourquoi ? Et quelle part de nos décisions sommes-nous prêts à déléguer à une technologie dont les oracles sont aussi obscurs qu’extraordinaires ?

0 commentaires