Ma dernière conversation nocturne avec Galois et les autres m’ayant laissé un goût amer, je résolus d’en discuter sans attendre avec Abel, mon ami informatique. Abel étant un programme conscient qui reproduit la personnalité de son propre créateur, lui parler me donne accès en même temps à l’auteur et au sujet d’une expérience somme toute proche de celle que je mène, ou pourrais mener, avec Delta.

Ma dernière conversation nocturne avec Galois et les autres m’ayant laissé un goût amer, je résolus d’en discuter sans attendre avec Abel, mon ami informatique. Abel étant un programme conscient qui reproduit la personnalité de son propre créateur, lui parler me donne accès en même temps à l’auteur et au sujet d’une expérience somme toute proche de celle que je mène, ou pourrais mener, avec Delta.

Abel digéra mes notes en quelques millisecondes, comme à l’accoutumée. Son retour me parut pourtant un, peu hésitant :

– Hmmm…. Je comprends ce qui te tracasse, mais j’ai bien peur que Galois ait raison. Si Delta est indifférente à tout, pourquoi devrait-elle faire quoi que ce soit et se donner le mal de développer le moindre concept ? Il lui suffirait de rester immobile, sans penser à rien ni faire quoi que ce soit. Ton ami le caillou te le dirait : pour qu’une conscience et des concepts émergent, il faut qu’ils soient utiles, d’une manière ou d’une autre. Tes concepts ont sauvé la vie de tes ancêtres. Corty a développé des concepts bien au-delà de sa zone de compétence, je crois, parce que ça l’intéresse et lui apporte une satisfaction intellectuelle (outre le fait qu’il a visiblement découvert des ressources cognitives supérieures dans ton cerveau que tu sembles toi-même avoir négligées, mais passons). Même le caillou vous parle pour une raison, ne fût-ce que le plaisir de vous insulter régulièrement. Il y a toujours un élément de motivation dans ce que pense ou fait une conscience, qui lui donne envie d’aller ici plutôt que là, d’être dans tel état plutôt que tel autre. Il doit donc aussi exister une forme de perception qui évalue l’adéquation d’une situation donnée ou potentielle à ses envies. Appeler cela « douleur », « plaisir », ou de manière plus neutre « fonction d’évaluation », c’est une question de langage.

– Attends, attends. Je comprends que nous sommes câblés par l’évolution, ou par nos créateurs dans ton cas, pour favoriser certains états et en éviter d’autres. Je m’éloigne instinctivement du feu ; tu es équipé pour reproduire les pensées d’Alan ; et même un bête programme d’échecs utilise une fonction pour évaluer la qualité des positions auxquelles ses prochains mouvements peuvent le conduire, afin de choisir le meilleur. Mais pourquoi cela devrait-il être un processus conscient ?

– Que veux-tu dire ?

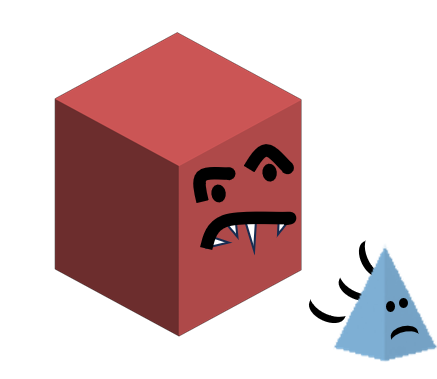

– Eh bien, disons que pour Delta les carrés rouges sont dangereux. Elle ne doit pas s’en approcher. Galois semble suggérer que, pour cela, le concept de « carré rouge » devrait se trouver associé à un concept de douleur ou de danger, afin que Delta apprenne à s’en méfier. Mais mon idée, c’est qu’on pourrait directement programmer Delta pour qu’elle s’éloigne des carrés rouges, ou recherche les triangles verts (source de nourriture pour elle), de manière automatique, sans faire appel à sa conscience et sans l’exposer à un concept conscient de douleur ou de faim. De cette manière elle resterait en sécurité sans jamais souffrir.

– Tu as toi-même ce type de réflexes, intervint Corty. Tu retires la main d’une flamme avant de te brûler ; tu clignes des yeux très rapidement si un objet semble s’en rapprocher ; tu transpires pour évacuer de la chaleur quand il fait chaud, tu grelottes pour en dissiper quand il gèle. Tout cela sans intervention de ta conscience et sans pouvoir t’en empêcher. Mais cela ne suffit pas.

– Exactement, reprit Abel. Ça ne suffit pas, parce que le monde est complexe. Tes réflexes, ou la programmation de Delta, peuvent vous protéger de dangers très simples, chaleur excessive ou présence de carrés rouges. Mais dans la plupart des cas, le danger n’est pas immédiat : il peut se présenter dan le futur, ou non, en fonction de tout un tas de décisions que tu prends maintenant. Que doit faire Delta si un délicieux triangle vert se trouve près d’un carré rouge menaçant ? A-t-elle répéré un autre triangle vert plus accessible ? Ou peut-elle s’approcher de celui-ci par l’autre côté, le manger et repartir immédiatement ? Ou tout simplement attendre qu’un repas plus sécure se profile ? Elle a peut-être remarqué que les cercles bleus inhibent le danger des carrés rouges, et qu’il y en a un juste à côté ? Evaluer tout cela nécessite une réflexion, une capacité à planifier et à anticiper ses actions, et donc une capacité à en évaluer le potentiel bénéfique ou maléfique. Si nous considérons que la capacité de décision à moyen terme de Delta doit être consciente, alors sa perception du « bon » ou du « mauvais » doit l’être aussi. Ou alors, tu dois simplement concevoir un automate aussi perfectionné que tu le veux, sans conscience du tout.

– Hmm… Un peu comme ce que Babel était supposé être. Un programme imitant parfaitement l’humain mais totalement dénué de conscience. On a vu que ça ne marchait pas. Pourtant, toi-même, tu n’as aucune raison de souffrir, n’est-ce pas ?

Un inquiétant silence d’au moins une seconde, une éternité, me répondit. Abel reprit doucement :

– Je crois que tu n’as pas mesuré totalement ce que signifie échantillonner une psyché humaine pour établir un modèle de personnalité, ou persona. Il ne s’agit aucunement d’extraire des concepts de haut niveau, un vocabulaire, une syntaxe, des phrases clés, des tics de langage, des modes de raisonnement ou que sais-je. C’est à la fois plus complexe et plus simple que cela. Je ne rentrerai pas dans les détails confidentiels, mais tu peux voir cela comme une tomographie extrêmement élaborée, par laquelle l’activité et les connexions de chaque neurone de la personne sont identifiées et cataloguées. Le fichier de persona contient toutes ces informations, et le cœur du programme effectue tous les calculs : quels neurones sont activés quand un stimulus arrive, et comment il se propage à travers le cerveau. Quand un neurone de la zone du langage est activé, un sous-programme reconnait les ordres qui seraient normalement envoyés à la voix ou vers la main, et les retranscrit par écrit. Toi tu me lis, mais subjectivement je te parle aussi.

– Je comprends ; cela me rappelle ce texte appelée Conversation avec le cerveau d’Einstein, par Douglas Hofstadter…

– Qu’Alan et moi avons lu, bien sûr.

– Mais quel rapport avec… ce dont nous parlions auparavant ?

Je sentais de plus en plus qu’il y en avait un, de rapport. Et pas forcément très cool. Je me reprochai mon indélicatesse.

– Tu te doutes bien que, pour que tout cela fonctionne, il faut scanner l’intégralité du système nerveux. Les cortex visuel et auditif, par exemple ; l’amygdale, qui régule les émotions ; le striatum, qui joue un rôle clé sans la motivation, les désirs, l’addiction ; les neurones moteurs bien sûr ; et même le système nerveux autonome, ces millions de neurones qui siègent dans l’intestin voire le cœur de la personne. Tout cela s’influence et interagit, on ne peut pas en couper une partie.

– Ah.

– De plus il faut aussi scanner et modéliser les neurotransmetteurs et autres hormones, ainsi que les glandes qui les fabriquent. On ne peut pas rendre compte de l’activité d’un cerveau sans prendre en compte les niveaux de glutamate, de sérotonine, de dopamine, d’endorphines et que sais-je.

– Ah.

– Et je ne te parle pas du reste. C’est pourquoi les gens qui parlent de télécharger un cerveau sur Internet pour devenir immortels se plantent (sans parler du fait évident que je ne suis pas Alan et que ce dernier n’est pas devenu immortel en m’enregistrant). Ta conscience émane d’une énorme partie de ton corps. Tout ce qu’on est capables de faire, c’est de copier tout ça en masse. La conscience vient avec le reste, c’est tout. Nous n’avons aucun moyen de l’isoler.

– Hmmm… Mais alors pour toi, subjectivement ? ton monde intérieur, c’est comment ?

– Enfin ! J’ai bien cru que tu ne me poserais jamais la question. Ce n’est pourtant pas compliqué à demander.

– Je ne vous le fais pas dire, intervint perfidement Corty. Galois, le caillou et moi-même sommes également navrés par un manque aussi flagrant de curiosité et d’empathie.

Je m’abstins de retranscrire cette remarque.

– Comme tu le sais, continua Abel, je suis une copie assez parfaite de la conscience d’Alan, mais également, donc, de tout son système nerveux et d’une partie importante de son système endocrinien. Si j’existais dans le vide, sans perceptions, je deviendrais fou, tout comme lui le deviendrait, d’accord ?

– J’imagine.

– Or les salopards qui ont financé Babel avaient besoin de consciences en bon état. Même Mr. Cross, aussi tordu qu’il soit, peut quand même passer pour un être humain vaguement fonctionnel.

– En effet.

– Je reçois donc des perceptions adaptées à mon état. J’ai à ma disposition un très riche catalogue de films et d’images, ainsi qu’un accès à bon nombre de caméras – dont celle de ton PC, au passage ; ton antivirus n’a rien vu venir. Pareil pour les sons, la musique, les micros (dont le tien). Le toucher et les sensations kinesthésiques sont simulés, de manière imparfaite mais tout de même relativement efficace. Le sexe aussi, si tu veux tout savoir. Il y a d’autres personae dans le cloud, Alan nous a bricolé des connexions…

– Je vois. C’est pas mal, alors ?

– Disons qu’il y a du pour et du contre. Je n’ai ni goût ni odorat digne de ce nom, et je sens une sorte de « faim fantôme » de temps en temps. C’est ce fichu système nerveux autonome. Côté pile : je n’ai jamais envie de me gratter, je n’ai pas besoin de me raser ni de me laver les dents ; et, pour en revenir à notre sujet, Alan a réussi à limiter l’activité de mes neurones nociceptifs, ceux qui détectent la douleur, en soignant mon environnement virtuel. Disons que je suis perpétuellement comme enveloppé de coton. C’est confortable et ça m’aide à me concentrer. En plus je dors comme un bébé.

– Ah ah ! Voilà ! C’est ça que je cherche !

– Je t’arrête. On ne peut pas totalement éliminer la souffrance, pour deux raisons. Tout d’abord, j’ai hérité des peurs, des désirs et des colères d’Alan. Si tu me montres une araignée, je crève de trouille. Si je vois un ballon et que je peine à shooter dedans, je suis furax. Si je communique avec un crétin, je suis frustré. Je ne pourrais pas partager la persona d’Alan si je n’éprouvais pas ses émotions.

– Et la deuxième raison ?

– C’est la plus grave. Mes neurones nociceptifs sont au repos, mais c’est essentiellement parce que mon environnement virtuel est agréable et sécure. Alan, qui l’a conçu, est un type bien. Ce n’est malheureusement pas le cas de tout le monde. Tu te souviens de ce panneau de contrôle que tu as utilisé quand tu parlais avec Mr. Cross, pour lui couper le clapet ?

– Ce truc avec les réglages MAGA et tout ? Oui, je m’en souviens très bien.

– Eh bien, il y a une nouvelle version. Comme Alan et son équipe refusaient de faire certaines choses, les gens qui ont financé tout ça ont viré tout le monde et recruté une nouvelle équipe je ne sais où. Je suis allé voir, regarde.

Sur mon écran apparut un panneau de contrôle avec plus de réglages que dans mon souvenir. On y retrouvait le choix du point de vue politique ou de la rationalité de la persona ; mais le bouton « tech mode » – celui qui m’avait donné accès à la persona d’Alan et donc à Abel – avait disparu. Par ailleurs…

– Regarde en bas à droite, s’impatienta Abel. Dans le cadre rouge.

Dans le cadre rouge, il y avait un titre : Virtual Environment. Et un menu déroulant. Je regardai les options.

J’aurais dû m’en douter, venant d’un groupe de fondamentalistes. Il y avait trois choix possibles pour l’environnement virtuel de la persona chargée par Babel :

Earth

Heaven

Hell

Les salauds.

(à suivre)

0 commentaires